티스토리 뷰

매~~우 늦어버렸지만 2주차 스타트!

(이제부터 벼락치기 제발 노.. 내 자신아)

2주차 챕터 3에서는 회귀 알고리즘과 모델 규제에 대해서 배웠다.

농어의 두께, 길이, 높이가 주어졌을 때 머신러닝 알고리즘을 이용해서 구하는 것.

03-1 K-최근접 이웃 회귀

회귀: 회귀는 클래스 중 하나로 분류하는 것이 아니라 임의의 어떤 숫자를 예측하는 것.

- 회귀는 정해진 클래스가 없고 임의의 수치를 출력함.

K-최근접 이웃 분류 알고리즘이란,

예측하려는 샘플에 가장 가까운 샘플 k개를 선택 후 이 샘플들의 클래스를 확인하여 다수의 클래스를 새로운 샘플의 클래스로 예측함.

이때 reshape() 메서드: 바꾸려는 배열의 크기를 지정함.

회귀에서는 정확한 숫자를 맞히는 것은 불가능

그래서! 결정계수를 통해 평가함.

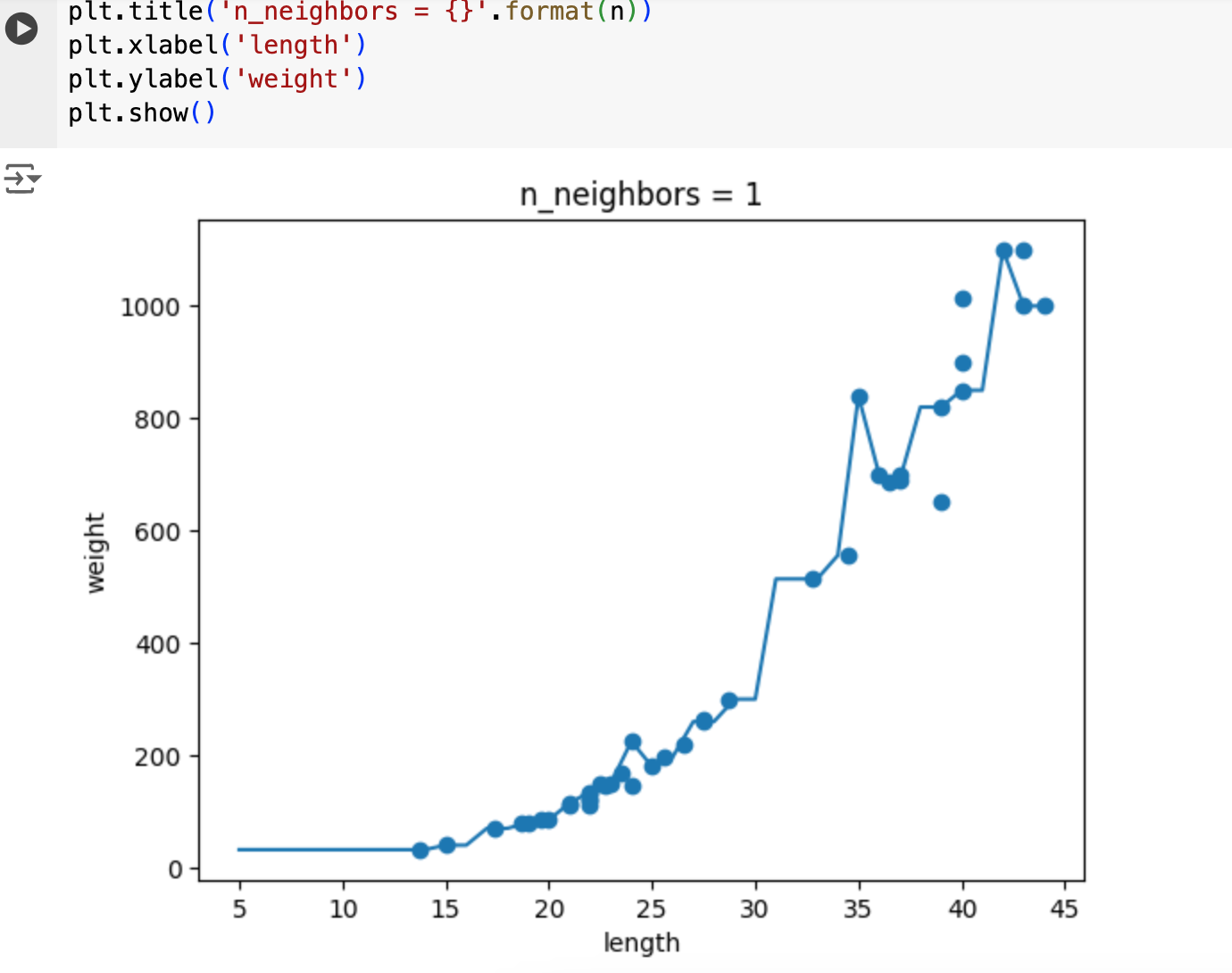

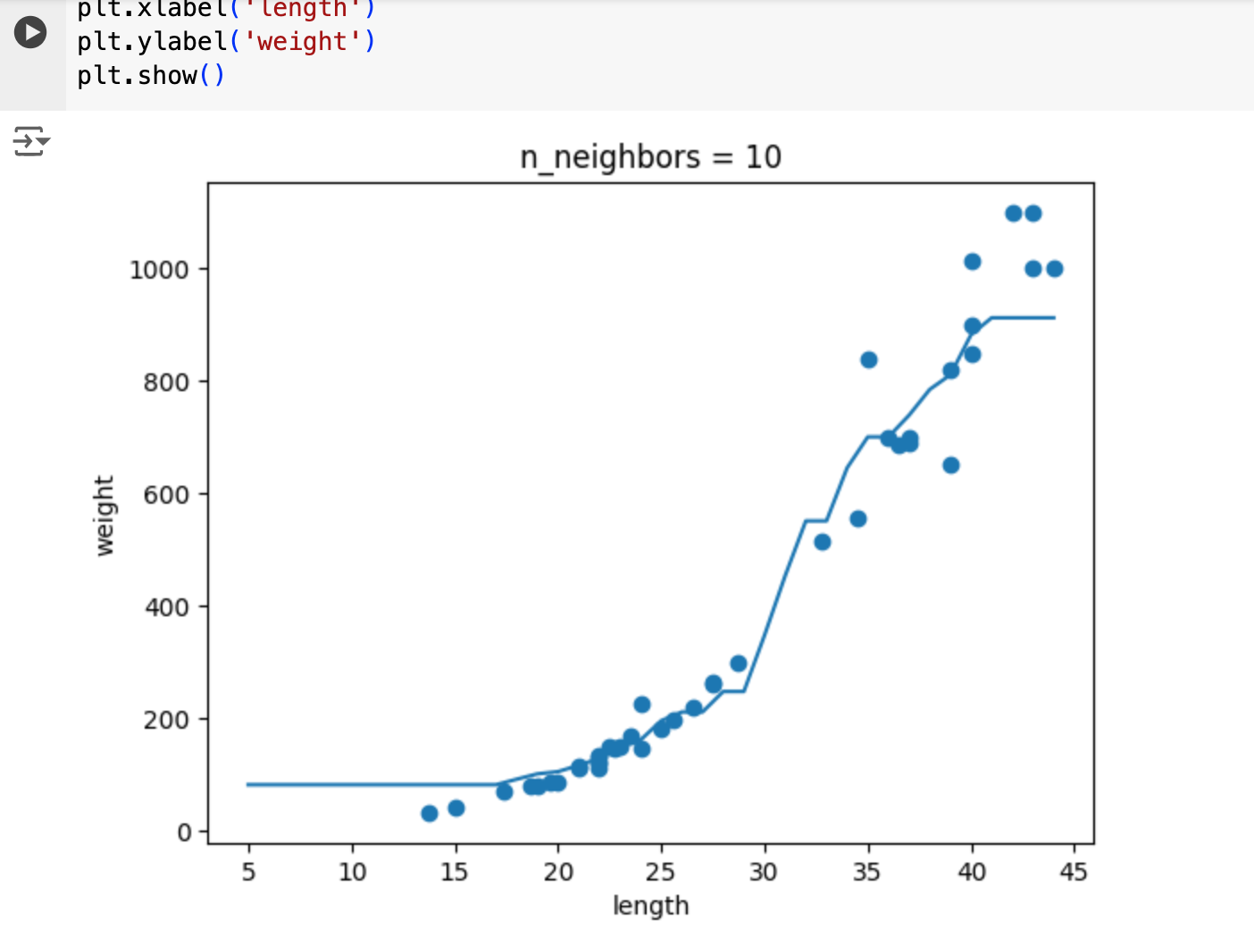

과대적합과 과소적합

과대적합: 훈련세트와 테스트 세트의 점수를 비교했을 때 훈련세트가 너무 높으면 과대적합.

과소적합: 위와 반대이거나 두 점수가 모두 낮으면 과소적합.

과소적합의 원인으로는, 테스트 세트의 크기가 작을 경우.

과소적합일 경우 모델을 복잡하게 만들면 됨. -> k의 개수 줄이기

--> 지금 하는 프로젝트를 위해 약간 무지성으로 추천 시스템을 구현하는 도중 저 k의 값에 따라 추천의 정확도가 달라지는 것을 보았다.

당시에는 구현에 급급해서 이게 뭐지할 시간도 없었지만 지금 공부를 해보니까 저 k는 샘플링의 개수를 의미했고 내가 마주했던 문제는 과소적합이었던 것 같다. 최적의 k값을 어떻게 찾는지 궁금증이 생기는데 이는 5장에 나온다고 하니까 좀 더 공부해봐야겠다.

숙제

답은 n, knr.predict(x)

실행화면

03-2 선형 회귀

K-최근접 이웃의 한계:

k-최근접 회귀의 경우 가장 가까운 샘플을 찾아 타깃을 평균함. 따라서 새로운 샘플이 훈련 세트의 범위를 벗어나면 앙뚱한 값을 예측한다는 문제!

이를 해결하기 위한 선형 회귀 알고리즘

선형회귀: 대표적인 회귀 알고리즘. 특성이 하나인 경우 어떤 직선을 학습하는 알고리즘.

여기서 기울가와 절편이 있어야 함. y = a * x + b -> 직선 방정식

LinearRegression 클래스는 이 a, b를 찾는데 coef_와 intercept_ 속성에 저장함.

이 둘은 모델 파라미터라고 하는데, 머신러닝 알고리즘 훈련은 모델 파라미터를 찾는 과정임.

-> 모델 기반 학습.

--> 내가 배웠던 추천 시스템에는 콘텐츠 기반, 협업 필터링 기반, 모델 기반이 나오는데 아마 그 모델 기반이 아닐까 싶다.

다항회귀:

다항식을 사용한 선형 회구를 다항 회귀라고 함.

0 이하로 내려가는 것을 막기 위해 최적의 곡선을 찾음.

-> column_stack() 함수 사용

03-3 특성공학과 규제

농어의 길이 외에 높이와 두께 데이터도 이용 가능

-> 여러 개의 특성을 사용한 선형 회귀를 다중 회귀라고 함.

특성 공학:

기존의 특성을 사용하여 새로운 특성을 뽑아내는 작업.

이를 위한 데이터는 판다스의 데이터프레임 사용. csv 파일

사이킷런의 변환기 클래스 -> fit(), transform()

테스트 세트에서 음수가 나올 경우 -> 훈련세트에 너무 과대적합

-> 규제: 릿지와 라쏘 회귀 사용

릿지: 규제가 있는 선형 회귀 모델, 선형 모델의 계수를 작게 만들어 과대적합을 완화시킴.

라쏘: 릿지와 달리 계수 값을 아예 0읋 만들 수도 있음.

보통은 릿지가 효과가 좋다고 함.

흐아 어찌저찌 2주차 완이다.

사실 지금은 진도 나가기에 급급해서 완벽하게 이해를 하려면 복습이 필요할 것 같다.

처음 보자마자 이해하면 천재지..

암튼 3주차에는 꼭 미리미리 공부하길 바라며..

그리고 책으로만 공부하는게 뭔가 익숙하지 않은 기분이라서 동영상 강의를 적극 참고해야겠다.

https://www.youtube.com/playlist?list=PLVsNizTWUw7HpqmdphX9hgyWl15nobgQX

혼자 공부하는 머신러닝+딥러닝

이 책은 수식과 이론으로 중무장한 머신러닝, 딥러닝 책에 지친 ‘독학하는 입문자’가 ‘꼭 필요한 내용을 제대로’ 학습할 수 있도록 구성 되어 있습니다. 구글 머신러닝 전문가(Google ML expert)

www.youtube.com

아주 잘 설명해주시는 것 같으니 이번주에는 동영상 강의 가본다!

그럼 2주차 완.

'코딩 > 혼공학습단 12기' 카테고리의 다른 글

| [혼공머신] 1주차_Ch 01~02. 나의 첫 머신러닝 / 데이터 다루기 (0) | 2024.07.07 |

|---|

- Total

- Today

- Yesterday

- 제플린

- 노션

- 딥러닝

- 기획

- 혼공족

- 피그마

- 한빛미디어

- 혼공학습단

- 스피킹

- 자기계발

- 머신러닝

- 기본소득제

- ChatGPT

- 생산성

- 혼공머신

- 장점

- 박해선

- 패스트캠퍼스

- 인공지능

- 기본소득

- 코딩

- 아니마

- 패캠

- 고려해봐야할 사항

- 국비

- 챗gpt

- 개발

- 솔직후기

- 샘 알트만

- uizard

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 | 31 |